Shalini Kantayya sobre su nuevo documental, ‘ Coded Bias’, y la importancia de abrir la caja negra del diseño de algoritmos

Las protestas en todo Estados Unidos y en todo el mundo a raíz del asesinato de George Floyd han creado conciencia sobre las desigualdades estructurales. Aunque el enfoque específico se ha centrado en la brutalidad policial, los académicos, activistas y artistas están haciendo sonar la alarma sobre cómo se ha amplificado el racismo sistémico en otras áreas, como la industria tecnológica, a través de la tecnología de comunicación y vigilancia.

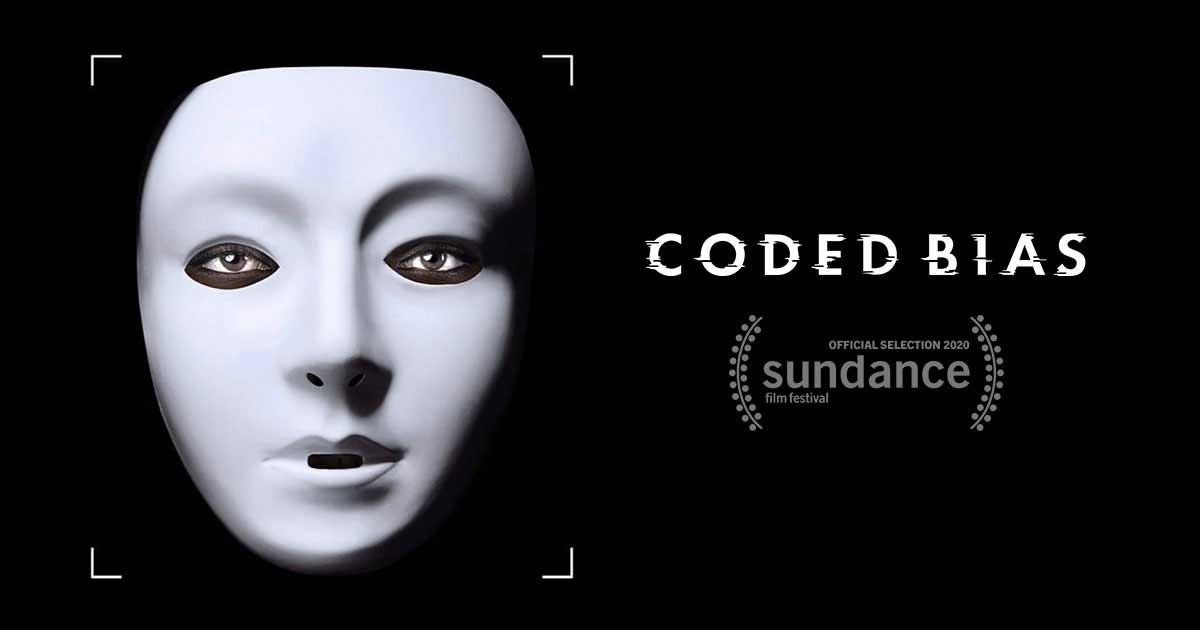

En Coded Bias , un documental de Shalini Kantayya, la directora sigue a la investigadora del MIT Media Lab y a la fundadora de Algorithmic Justice League , Joy Buolamwini , mientras descubre uno de los problemas fundamentales con el reconocimiento facial. Mientras trabaja en un proyecto de arte de reconocimiento facial, Buolamwini se da cuenta de que el software de visión por computadora tenía problemas para rastrear su rostro, pero funcionó bien cuando se puso una máscara blanca. Fue solo la evidencia más reciente del tipo de sesgo que está integrado en los sistemas de reconocimiento facial y AI

Junto con Buolamwini, Kantayya entrevista a autores, investigadores y activistas como Cathy O’Neil , Meredith Broussard , Safiya Noble y Silkie Carlo , desentrañando los problemas de la tecnología actual como el reconocimiento facial o el software de predicción de delitos . Estas tecnologías a menudo se conectan con las oscuras prácticas históricas de vigilancia racializada, eugenesia o fisonomía .

La película, que se proyectó en Sundance , enfoca un ojo crítico en la supuesta «objetividad» de los algoritmos, que O’Neil define como «usar información histórica para hacer una predicción sobre el futuro». Si bien los algoritmos a menudo se entienden como imparciales, objetivos y amorales, pueden reproducir los prejuicios de los humanos que los crean. Broussard dice que le damos a la tecnología «pensamiento mágico», que elogia sus beneficios pero oculta sus efectos negativos.

El sesgo codificado explica cómo el sesgo algorítmico puede tener efectos negativos en el mundo real. La película muestra cómo un distrito escolar de Houston utilizó un algoritmo secreto en su sistema de evaluación de maestros de «valor agregado», que clasificó incluso a los maestros premiados como «malos maestros»; o cómo el software de reconocimiento facial que usa la policía a menudo identifica erróneamente a los sospechosos negros.

La película también muestra cómo las tecnologías que están profundamente arraigadas en nuestras vidas aumentan la dinámica de poder asimétrica existente. Los algoritmos que dan forma a la vida de las personas a menudo están ocultos en una «caja negra», construida por grandes empresas tecnológicas que utilizan protecciones de derechos de propiedad para evitar que el público sepa cómo funcionan sus algoritmos y qué datos se recopilan.

Kantayya habló por teléfono con OneZero sobre cómo aprendió sobre el sesgo algorítmico y cómo espera que Code Bias pueda capacitar a los ciudadanos para comprender y proteger sus derechos.

Sesgo codificado se lanzará en teatros seleccionados este otoño. Este Q&A ha sido editado por su extensión y claridad.

OneZero: ¿Cómo aprendiste sobre el sesgo del algoritmo y qué te inspiró a hacer una película al respecto?

Kantayya: Gran parte de mi trabajo es sobre tecnología disruptiva y cómo los hacen más o menos justos e iguales. Los temas relacionados con la raza, el género y la clase son cosas en las que tiendo a pensar, y descubrí el trabajo de mujeres como Joy Buolamwini, Cathy O’Neil y Zeynep Tufekci . Me interesé en el bajo vientre de la gran tecnología y eso me envió por el agujero del conejo.

¿Cuáles son algunas de las instancias de sesgo algorítmico que aparecen en la película?

Había un algoritmo de Amazon que no intentaba ser sesgado, pero el algoritmo recogió el sexismo pasado en las prácticas de contratación y retención, y comenzó a clasificar a cualquier mujer que tuviera una universidad o deporte femenino en su currículum . Sin saberlo, esta IA discriminó a las mujeres en el proceso de contratación. La parte central de la película es que el reconocimiento facial no funciona tan bien en los rostros oscuros o en las mujeres , y sin embargo, esas son las personas que son más objetivo de los perfiles raciales. Recientemente, un hombre en Detroit estuvo recluido durante 30 horas por haber sido identificado erróneamente por reconocimiento facial . Entonces los ejemplos están realmente en todas partes.

¿Qué deben hacer las empresas, las personas que están creando esta tecnología, para eliminar algunos de los sesgos que se codifican en sus algoritmos?

El público de mi película no es en realidad tecnólogos. La audiencia es en realidad ciudadanos. ¿Deberían las empresas ser más responsables o inclusivas en sus prácticas de contratación o quién está en la sala cuando se están construyendo estas tecnologías? Absolutamente. Pero mi enfoque realmente no está en las empresas. Para mí, no se trata de hacer un algoritmo perfecto, se trata de hacer una sociedad más humana. La película trata de capacitar a los ciudadanos para que comprendan estas herramientas para que podamos tener leyes y protecciones contra estas prácticas; de modo que no dependerá de las compañías tecnológicas vender su tecnología al FBI o la policía u otras entidades sin que una persona elegida esté al tanto. El hecho de que las corporaciones estén haciendo esto no lo hace mejor que cuando lo hace un gobierno.

¿Cuáles son algunas de las formas en que los ciudadanos comunes pueden luchar contra estos sistemas de vigilancia?

Creo que tenemos un momento donde la gran tecnología está escuchando. En el último mes, IBM dijo que básicamente saldría del juego de reconocimiento facial: deja de investigarlo, deja de ofrecerlo, deja de venderlo. Amazon dijo que presionaría pausa durante un año en su venta a la policía, y Microsoft dijo que también dejaría de vender a la policía. Así que siento que debido a que tenemos este movimiento por la igualdad en las calles, tenemos un momento para aprobar una legislación significativa. Y creo que debemos presionar por legisladores que protejan nuestros datos como parte de los derechos humanos y nos protejan de estas tecnologías invasivas que violan nuestros derechos civiles.

Artículo publicado en One Zero

Comments are closed